요즘 세상을 떠들썩하게 만들고 있는 DeepSeek를 내 PC에 직접 설치하여 나만의 AI로 활용하는 방법을 알아보도록 할게요. DeepSeek에 대해서는 많은 설명들이 있으니 이번 포스팅에서는 DeepSeek-R1을 로컬에 설치하는데 집중하겠습니다.

1. DeepSeek-R1

DeepSeek R1은 오픈소스의 대형 언어모델(LLM)로 ChatGPT와 같은 상용 모델과 견줄말한 성능을 가지고 있으며 대표적인 특징은 아래와 같습니다.

- 오픈소스 : 누구나 코드 수정 및 파인 튜닝을 쉽게 할 수 있음

- 추론 능력 : 복잡한 질문에 단계별 사고 과정을 보여줌

- 데이터 프라이버시: 로컬에서 실행하면 외부 서버로 데이터 전송 없이 사용할 수 있음.

현재 정보유출로 많은 이슈가 있기에 데이터 프라이버시는 로컬로 설치하여 사용하는 큰 목적중 하나일 것입니다.

2.시스템 사양

소형모델(7B~8B)와 중형이상의 모델(14B 이상)으로 구분할 수 있으며 소형 모델 기준은 다음과 같습니다.

- 소형모델

- GPU : VRAM 8GB (NVIDIA RTX 3060, RTX 3070)

- RAM : 32GB(권장, 최소 16GB 이상)

- CPU : 최신세대 멀티 코어 프로세스 (i5 또는 AMD Ryzen 5 이상)

- 저장공간 : 최소 10GB 이상의 SSD 권장

- 중형모델

- GPU : 최소 VRAM 16GB 이상 (RTX 4090, NVIDIA A100, H100)

- RAM :64GB(권장, 최소 32GB 이상)

- CPU : i7/i9 또는 Ryzen 7/0 이상

- 저장공간: 충분한 SSD공간

3.DeepSeek R1 설치

자 이젠 본격적으로 설치를 진행해 봅시다. 아래의 순서대로 천천히 진행해보세요

1) Ollama 설치

Ollama 공식 홈페이지에서 로컬PC의 운영체계에 맞게 설치 파일을 다운로드 합니다.

다운로드후 보통때와 같이 Next만 클릭하변 됩니다.

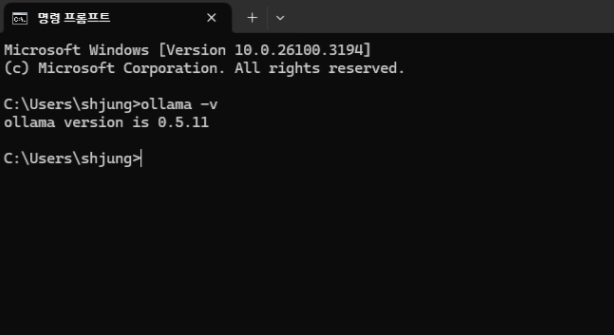

설치가 완료되면 터미널을 열어 (Window 검색창: cmd) 아래의 명령어로 설치가 제대로 되었는지 확인 해주세요

ollama -v

오류 없이 정상적으로 버전이 나왔다면 설치가 완료 된 것입니다.

2) DeepSeek R1 설치 하기

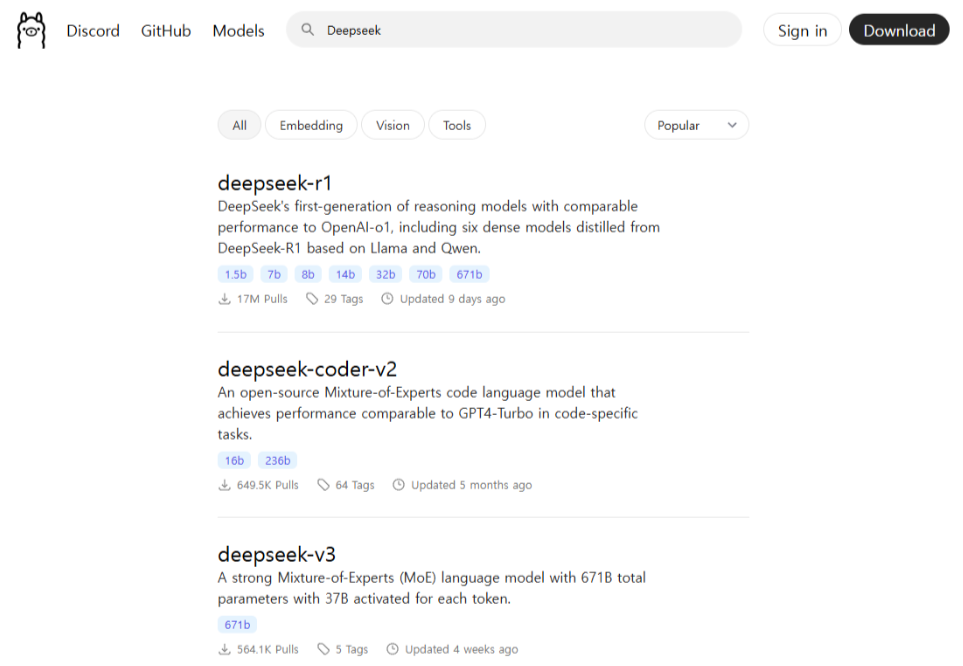

DeepSeek R1을 설치하기 위해 Ollama 사이트에 다시 접속을 합니다. 상단 Models 메뉴를 클릭 후 검색창에다가 DeepSeek라고 입력하시면 상단에 DeepSeek-R1 이 검색됩니다.

상세 페이지로 들어가서 설치하려는 모델의 ollama 명령어를 확인합니다. 여기서는 DeepSeek-R1-Distill-Llama-8B를 설치 할 것입니다. 화면에 나온 ollama 명령어를 복사해주세요

ollama run deepseek-r1:8b

터미널창에 복사한 실행코드를 붙여넣기 한 후 실행을 시키면 아래처럼 설치가 진행될 것입니다. 약 4~5GB 정도 용량이네요

설치가 완료되면 터미널 창에서 한번 간단한 질문을 해볼까요? 전 아래와 같이 질문을 해봤답니다.

Hi! How is it different from ChatGPT?아래와 같이 DeepSeek의 답변이 나온답니다.

4. Python에서 DeepSeek R1 실행하기

설치된 Deepseek R1을 Python에서 호출하여 실행 가능하답니다. 아래의 코드를 참조 해주세요

from ollama import chat

from ollama import ChatResponse

response:ChatResponse=chat(model='deepseek-r1:8b',messages=[{

'role':'user',

'content':'how is it different from chatgpt?',

},])

print(response['message']['content'])결과는?? 아래와 처럼 동일한 답변을 합니다. ^^

간단하게 로컬에서 DeepSeek R1을 설치하였습니다. 이젠 나만의 AI로 활용해 보시고 다음 포스팅에서는 DeepSeek R1을 GUI를 이용한 나만의 AI 활용 및 RAG에 대해서 포스팅하도록할게요~

댓글